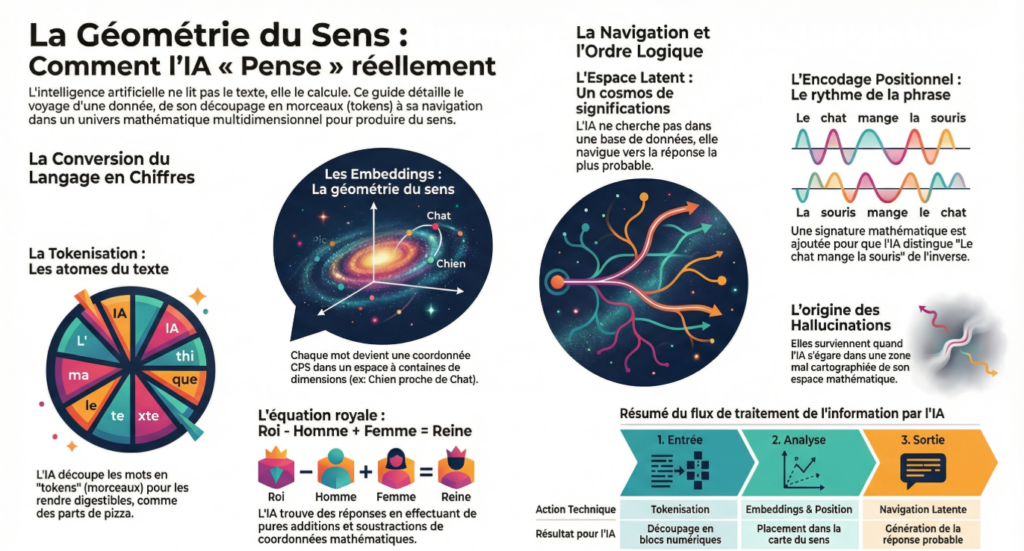

Nous avons souvent l’illusion que l’intelligence artificielle « lit » nos messages comme le ferait un humain. En réalité, l’IA est une pure machine mathématique. Elle ne comprend ni les lettres, ni les émotions, ni la poésie. Pour qu’elle puisse traiter notre langage, il faut un traducteur capable de convertir nos mots en nombres.

Ce cours vous invite à explorer la mécanique invisible de cette traduction. Oubliez l’interface de chat familière : nous allons plonger dans les rouages pour découvrir comment une machine parvient à transformer des concepts abstraits en une géométrie précise.

1. La Tokenisation : L’Analogie de la Mosaïque

Avant même de comprendre une phrase, l’IA doit la décomposer. Elle ne peut pas traiter le flux de texte comme un tout continu.

L’analogie de la Mosaïque :

Imaginez que vous observez une magnifique mosaïque romaine représentant un paysage.

- Votre phrase est l’image globale du paysage.

- Les tokens sont les petits carreaux de céramique (tesselles) qui la composent.

Pour l’ordinateur, l’image n’existe pas en tant que telle. Il ne gère qu’un sac de petits carreaux colorés. Il ne voit pas « une maison », il voit une suite de carreaux [rouge, rouge, gris, blanc]. De la même manière, l’IA ne lit pas des phrases, elle manipule une suite de petits carreaux de texte standardisés.

Le piège des mots longs :

L’IA ne voit pas le mot complexe « Spectrophotomètre « comme un bloc unique. Elle le découpe en plusieurs carreaux distincts (tokens), par exemple : [spec] [tro] [photo] [mètre].

C’est pour cette raison qu’elle a parfois du mal à compter les lettres ou à faire des rimes : elle ne voit pas les lettres individuelles à l’intérieur des carreaux, elle ne voit que les blocs assemblés.

2. Les Embeddings : La Fiche de Personnage (RPG)

Une fois le texte découpé en carreaux (tokens), comment l’IA comprend-elle le sens ? Elle attribue à chaque mot une liste de notes sur des critères universels. C’est ce qu’on appelle un Embedding.

L’analogie du Jeu de Rôle (RPG) :

Dans un jeu vidéo, tous les personnages (Guerrier, Magicien, Voleur) possèdent la même fiche de statistiques (Force, Intelligence, Vitesse). Ce qui change, ce sont les scores.

L’IA fait pareil : elle force tous les mots du dictionnaire à entrer dans la même grille d’évaluation comportant des milliers de critères.

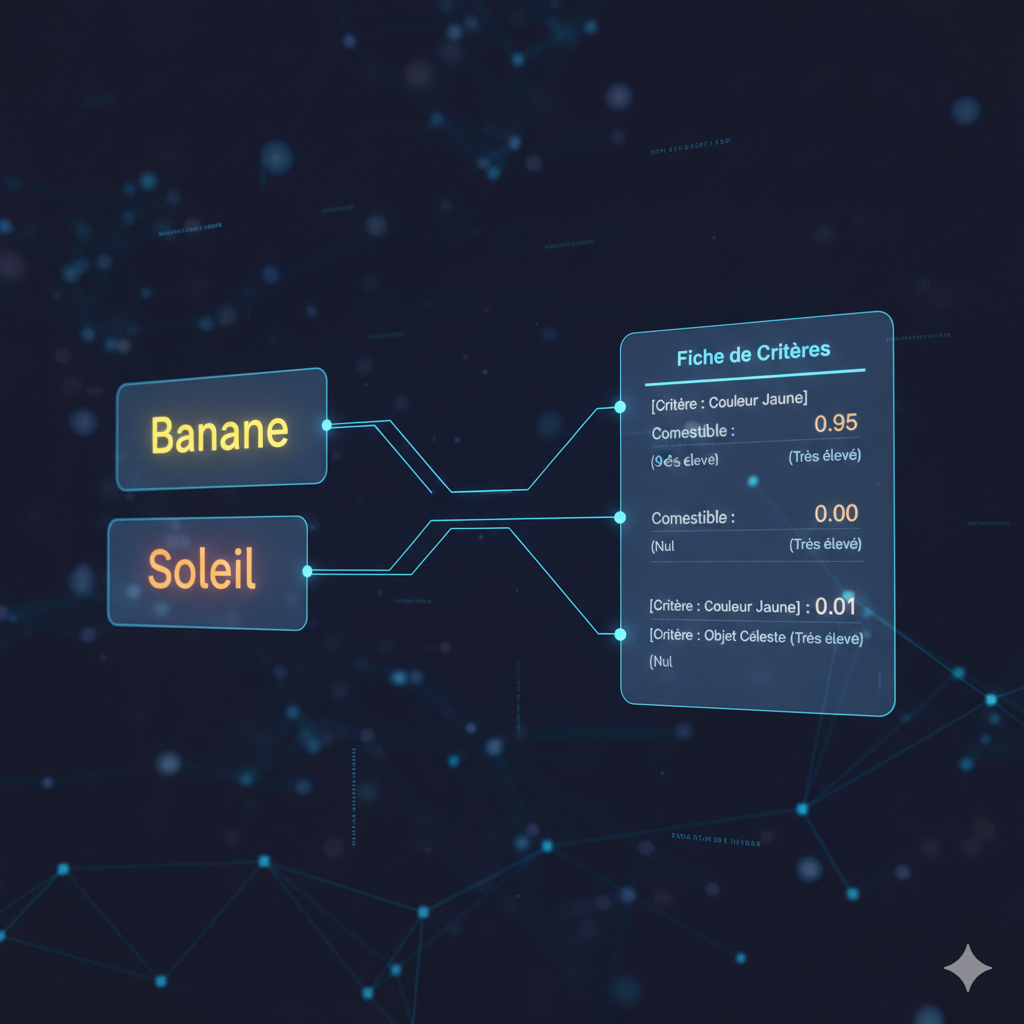

Prenons deux mots très différents : « Banane » et « Soleil ».

Pourquoi l’IA les rapprocherait-elle ? Regardons leurs fiches communes :

- Mot : « Banane »

- [Critère : Couleur Jaune] : 0.95 (Très élevé)

- [Critère : Comestible] : 0.99 (Très élevé)

- [Critère : Objet Céleste] : 0.01 (Nul)

- Mot : « Soleil »

- [Critère : Couleur Jaune] : 0.90 (Très élevé)

- [Critère : Comestible] : 0.00 (Nul)

- [Critère : Objet Céleste] : 0.99 (Très élevé)

Grâce à cette fiche commune, l’IA « voit » mathématiquement que la Banane et le Soleil sont des « cousins » sur l’axe de la couleur, même s’ils sont opposés sur l’axe de la nourriture.

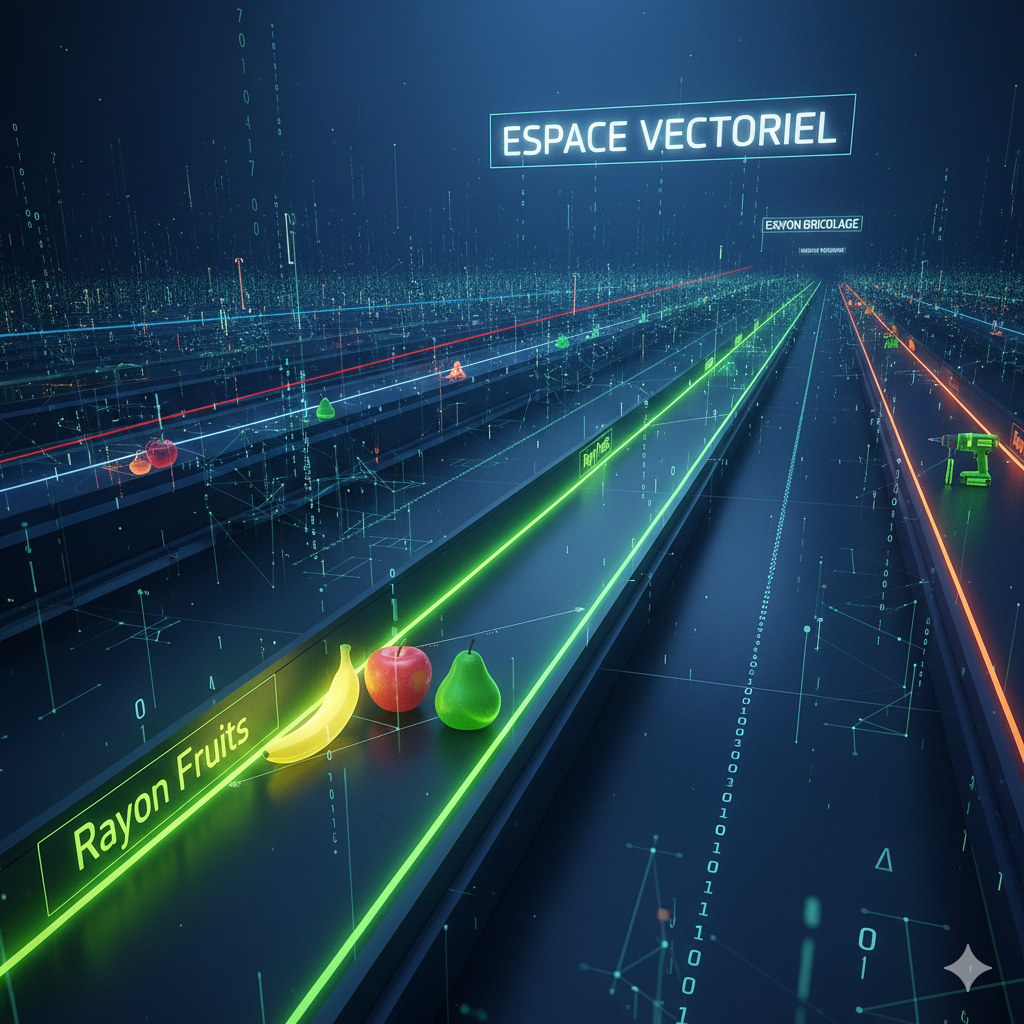

3. L’Espace Vectoriel : Le Supermarché Infini

Si chaque mot est une liste de coordonnées, alors tous les mots de la langue peuvent être placés sur une carte immense. C’est l’Espace Vectoriel.

L’analogie des Rayons de Supermarché :

Imaginez un supermarché gigantesque où l’organisation est parfaite.

- Au rayon « Fruits », vous trouvez la pomme, la poire et la banane rangées côte à côte.

- Au rayon « Bricolage », très loin de là, vous trouvez le marteau et la perceuse.

L’IA range les mots selon cette même logique de proximité. Si vous cherchez le mot « Roi », vous le trouverez physiquement stocké juste à côté de « Reine » et « Trône ». Par contre, il sera situé à des kilomètres du mot « Toaster ».

Pour l’IA, comprendre le sens d’un mot, c’est simplement savoir où il est rangé dans ce supermarché et qui sont ses voisins.

4. L’Encodage Positionnel : Les Tickets de File d’Attente

Les modèles d’IA modernes sont capables de traiter tous les mots d’une phrase en même temps (en parallèle) pour aller plus vite. Le problème, c’est qu’en faisant cela, on perd l’ordre des mots. « Paul aime Marie » devient un sac de mots mélangés où l’on ne sait plus qui aime qui.

L’analogie des Tickets Numérotés :

Imaginez une foule de personnes (les mots) qui entrent dans une administration en désordre. Pour rétablir l’ordre de passage, on distribue à chacun un ticket numéroté à l’entrée.

Même si tout le monde est dans la salle en même temps, le ticket n°1 indique qui est le sujet, le ticket n°2 le verbe, et le ticket n°3 l’objet.

L’encodage positionnel, c’est ce petit ticket mathématique agrafé à chaque mot pour que l’IA n’oublie jamais le sens de lecture et la structure de la phrase.

Mise en Pratique : 3 Scénarios

1. L’Arithmétique des Concepts (Calcul Vectoriel)

L’IA peut additionner et soustraire des sens comme des nombres.

- Exercice : Si vous prenez le concept [Hiver], que vous lui retirez la notion de [Froid] et que vous ajoutez la notion de [Chaleur], quel concept obtenez-vous ?

- Formule :

Vecteur(Hiver) - Vecteur(Froid) + Vecteur(Chaleur) = ?

- Formule :

- Réponse de l’IA : Elle tombera sur le point géométrique du mot [Été]. Elle a simplement déplacé le curseur sur l’axe de la température.

2. Le Radar à Intrus (Distance Sémantique)

L’IA mesure la pertinence en calculant la distance entre les mots dans son « supermarché ».

- Exercice : Dans la liste suivante, quel mot l’IA identifiera-t-elle comme une anomalie ?

- {Violon, Piano, Guitare, Moteur}

- Explication : Les trois premiers mots sont regroupés dans le « cluster » (groupe) des instruments de musique. Ils sont très proches les uns des autres (distance faible). Le mot « Moteur » est situé dans un cluster mécanique très éloigné. La « distance cosinus » entre Violon et Moteur est énorme, ce qui signale immédiatement à l’IA que ce mot n’a rien à faire là.

3. La Boussole des Analogies (Projection Géométrique)

L’IA est excellente pour compléter des analogies en reproduisant un mouvement géométrique (une flèche) d’un point A vers un point B.

- Exercice : Trouvez le mot manquant. [Paris] est à [France] ce que [Tokyo] est à [ ? ].

- Mécanisme : L’IA calcule le vecteur (la flèche) qui part de « Paris » pour aller à « France ». Ce vecteur représente la relation « est la capitale de ». Elle prend ensuite ce même vecteur et l’applique au point de départ « Tokyo ».

- Résultat : En suivant cette flèche depuis Tokyo, elle atterrit précisément sur les coordonnées du mot [Japon].

En refermant ce dossier, vous ne regarderez plus jamais une fenêtre de chat de la même manière. Ce que nous percevons comme une conversation fluide et intelligente n’est, pour la machine, qu’une immense partie de « connecter les points » dans un espace mathématique invisible.

Vous savez désormais que derrière chaque réponse impressionnante se cache une mécanique froide mais fascinante : des mosaïques assemblées (tokens), évaluées sur des fiches statistiques (embeddings) et rangées dans des rayons infinis (espace vectoriel).

Cette vision géométrique est votre meilleur atout. Comprendre que l’IA ne réfléchit pas mais calcule des distances vous permettra d’être plus indulgent face à ses erreurs et beaucoup plus précis dans vos demandes. Vous ne parlez pas à un cerveau, vous guidez un curseur sur une carte.